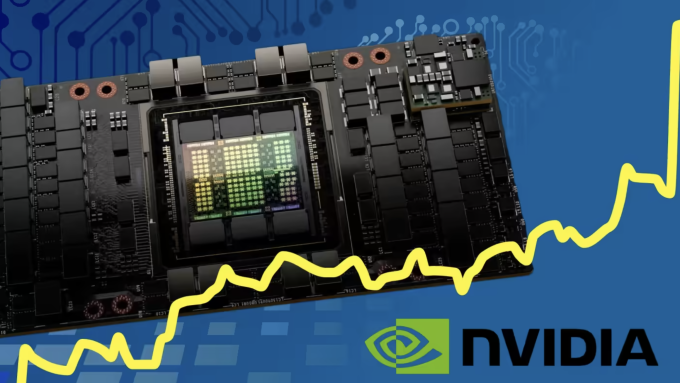

Chip H100 của Nvidia đóng vai trò đặc biệt quan trọng trong việc huấn luyện siêu AI, giúp công ty sắp gia nhập CLB nghìn tỷ USD.

Đầu năm 2022, Nvidia ra mắt H100 – bộ xử lý đồ họa GPU mạnh nhất từng chế tạo và cũng là một trong những chip đắt nhất hiện nay với giá 40.000 USD mỗi chiếc. Khi đó, giới chuyên gia nhận định Nvidia đã chọn sai thời gian công bố, bởi các doanh nghiệp đang tìm cách thắt chặt chi tiêu và sa thải nhân sự. Cho tới tháng 11 cùng năm, OpenAI tung ra ChatGPT.

“Chúng tôi trải qua một năm tương đối khó khăn, nhưng bước ngoặt đến chỉ sau một đêm”, Jensen Huang, CEO Nvidia, nói. “ChatGPT xuất hiện là khoảnh khắc tuyệt vời. Nó tạo ra nhu cầu ngay lập tức”.

Thành công bất ngờ của ChatGPT nhanh chóng tạo ra một cuộc chạy đua trong lĩnh vực AI tạo sinh, từ những gã khổng lồ công nghệ hàng đầu thế giới cho đến các công ty khởi nghiệp. Tất cả tìm đến H100, mẫu chip mà ông Huang mô tả là “hệ thống đầu tiên trên thế giới được thiết kế cho siêu AI”.

Tầm quan trọng của H100 thể hiện vào tuần trước khi Nvidia công bố doanh thu quý tài chính đầu tiên (từ tháng 2 đến tháng 4) là 7,19 tỷ USD, cao hơn nhiều so với mức dự báo 6,52 tỷ USD. Công ty ước tính doanh thu quý tiếp theo đạt 11 tỷ USD, hơn 50% dự đoán của Phố Wall.

Phản ứng tích cực từ giới đầu tư và nhà phân tích giúp giá trị vốn hóa công ty đã tăng mạnh 2,5 lần so với đầu năm, đạt hơn 960 tỷ USD, tiến gần cột mốc nghìn tỷ USD.

Sức mạnh của H100

Nvidia được đánh giá đã chiến thắng sớm trong làn sóng AI tạo sinh – công nghệ được dự đoán có khả năng định hình lại các ngành công nghiệp, tạo ra năng suất khổng lồ và thay thế hàng triệu việc làm. Bước nhảy vọt này được thúc đẩy bởi H100 – chip được phát triển dựa trên kiến trúc Hopper mới nhất và được đặt tên theo người tiên phong về lập trình Grace Hopper.

H100 là bản kế nhiệm của A100 giá 10.000 USD và được mệnh danh là “ngựa thồ” của ngành trí tuệ nhân tạo. Trong huấn luyện AI, GPU chiếm ưu thế so với CPU nhờ khả năng tiến hành song song hàng loạt tính toán. Các nhà phát triển đang sử dụng A100 và H100 để xây dựng mô hình ngôn ngữ lớn (LLM), cốt lõi của ứng dụng AI như ChatGPT.

Chip mới nhất của Nvidia được trang bị 80 tỷ bóng bán dẫn, nhiều gấp năm lần so với bộ xử lý trên iPhone 14 Pro Max và gấp đôi A100, nhưng lại có sức mạnh gấp ba lần bản tiền nhiệm. “H100 giải quyết được câu hỏi về khả năng mở rộng mô hình AI lớn – thứ đang gây khó khăn cho doanh nghiệp theo đuổi trí tuệ nhân tạo. Nó cho phép họ đào tạo mô hình ngôn ngữ lớn nhanh hơn nhiều”, Emad Mostaque, CEO của Stability AI, nhận xét.

Nvidia hiện có nhiều kỹ sư phần mềm hơn kỹ sư phần cứng nhằm tối ưu hóa GPU của họ cho mục đích đa dạng, giúp chip hoạt động hiệu quả hơn trong tính toán thống kê và huấn luyện mô hình LLM khác nhau. Theo Nathan Benaich, chuyên gia của Air Street Capital – công ty đầu tư vào các công ty khởi nghiệp AI, Nvidia đã nhìn thấy tương lai về GPU có thể lập trình. “Nvidia thấy cơ hội và đặt cược lớn, giúp họ liên tục vượt xa đối thủ cạnh tranh. Họ đang đi trước đối thủ khoảng hai năm”, ông nói.

Đắt nhưng vẫn “cháy hàng”

Sức mạnh của H100 khiến nó đang trở thành mặt hàng hot nhất tại Thung lũng Silicon. “Việc sản xuất chip này trên quy mô lớn bắt đầu chỉ vài tuần trước khi ChatGPT ra mắt”, Huang cho biết.

Niềm tin của Nvidia được chắp cánh khi hợp tác với TSMC, hãng sản xuất chip theo hợp đồng lớn nhất thế giới. Theo Huang, bắt tay với hãng Đài Loan giúp họ nhanh chóng mở rộng quy mô H100, đáp ứng nhu cầu bùng nổ từ các nhà cung cấp dịch vụ đám mây như Microsoft, Amazon và Google cho đến các công ty khởi nghiệp về AI.

Chưa có GPU nào vượt qua H100 về sức mạnh. “Đó là một trong những nguồn tài nguyên kỹ thuật khan hiếm nhất hành tinh”, Brannin McBee, người sáng lập CoreWeave – công ty khởi nghiệp cơ sở hạ tầng đám mây tập trung vào AI, nói. CoreWeave là một trong những đối tác đầu tiên nhận được lô hàng H100 đầu năm nay.

Một số khách hàng khác phải đợi sáu tháng mới có thể nhận H100. Elon Musk, người đặt hàng 10.000 chip của Nvidia cho X.AI, nhận xét trong phỏng vấn với WSJ tuần trước rằng việc mua GPU giờ “khó hơn nhiều so với thuốc”.

“Chi phí cho các hệ thống AI tăng lên chóng mặt. Số tiền đặt cược tối thiểu phải là 250 triệu USD cho phần cứng máy chủ để xây dựng hệ thống AI sáng tạo”, Musk nói.

Ian Buck, đứng đầu bộ phận kinh doanh của Nvidia, cho biết nhiệm vụ khó khăn nhất của công ty là tăng nguồn cung H100 để đáp ứng khách hàng. “Nhu cầu thị trường siêu lớn. Nhiều đơn vị đang tìm mua hàng chục nghìn GPU”, ông nói.

Trong khi đó, một số chuyên gia nhận định Phố Wall có vẻ đang “nhiệt tình quá mức” với Nvidia. Dù vậy, vị thế của công ty chip trên thị trường AI là không thể bàn cãi.

“Toàn bộ thị trường chip cho siêu AI thuộc về Nvidia”, Jay Goldberg, nhà sáng lập công ty tư vấn chip D2D Advisory, đánh giá.

Theo https://vnexpress.net/chip-do-hoa-40-000-usd-giup-sieu-ai-bung-no-4610797.html